Le modèle des bandits manchots est un modèle statistique bien connu en machine learning, mais souvent (trop) peu exploité en marketing.

Une introduction au modèle des bandits manchots et à son usage en marketing

Découvrez comment exploiter la théorie des bandits manchots, un modèle d’apprentissage par renforcement, dans différents domaines du marketing.

Qu’est ce qu’un bandit manchot ?

C’est un modèle d’apprentissage statistique, dont le but est de faire un choix séquentiel entre plusieurs actions en fonction des récompenses qu’elles génèrent.

L’exemple d’application qui a donné son nom au modèle est le choix entre plusieurs machines à sous ,“machine à sous” se traduisant par “one-armed bandit” en anglais. Le cadre est le suivant : un joueur a le choix entre plusieurs machines à sous (appelées aussi bras) dont il ne connaît pas à l’avance la rentabilité moyenne. C’est d’ailleurs cette ignorance des rentabilités qui en fait un problème d’apprentissage. Le joueur dispose d’un certain budget, constitué par exemple de N pièces de 1 euro et doit jouer une à une ces pièces sur les différentes machines à sous. Le but est d’amasser le plus d’argent possible au bout des N tirages. La récompense donnée par la machine à sous choisie est une variable aléatoire tirée d’une certaine loi de probabilité.

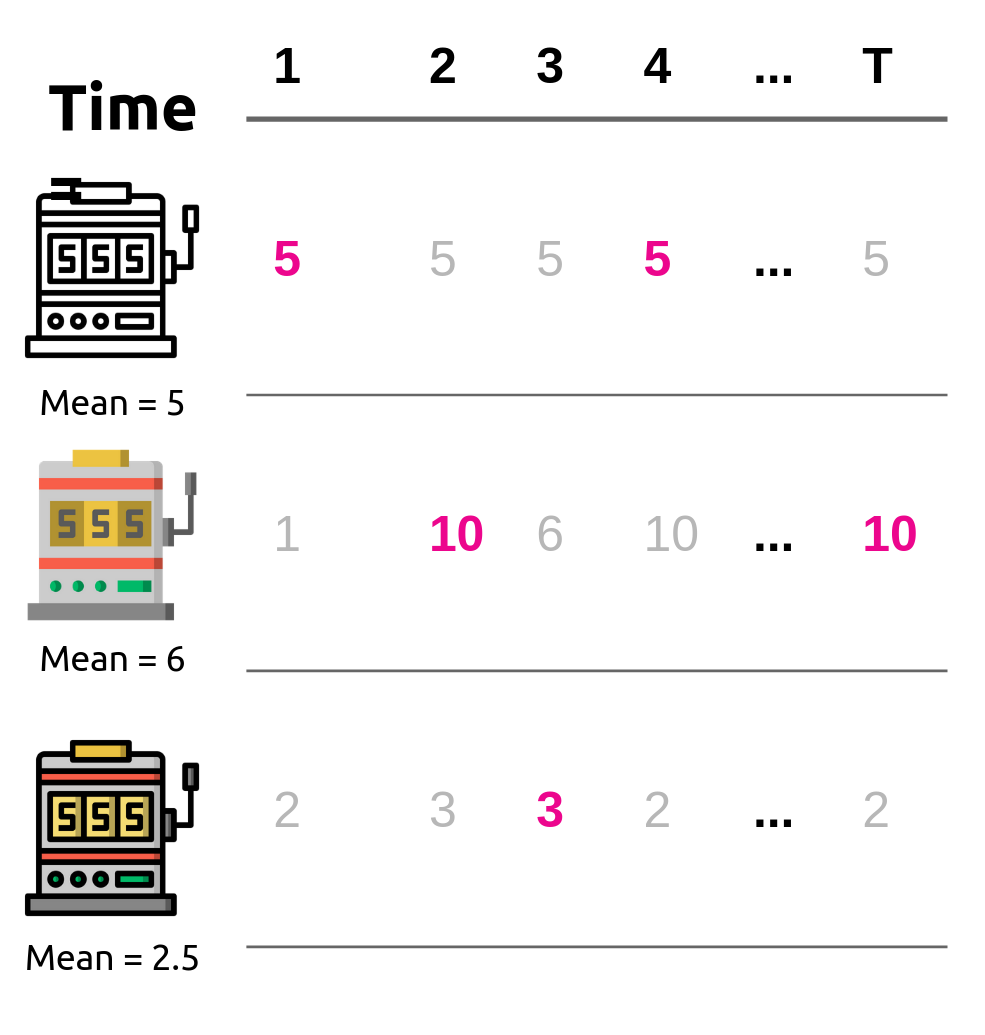

On peut considérer de façon équivalente qu’à chaque tour, des récompenses sont tirées des machines à sous qui n’ont pas été choisies mais qu’elles ne sont ni observées ni collectées par le joueur, comme dans la figure ci-contre, où les récompenses observées sont représentées en couleur.

Dans cet exemple, le joueur va donc devoir allouer une certaine somme à la recherche des machines à sous les plus rentables (c’est ce qu’on appelle l’exploration) et le reste du budget à investir dans ces machines à sous (c’est ce qu’on appelle l’exploitation). Le problème des bandits manchots se résume donc à résoudre un compromis exploration/exploitation qui consiste à choisir quand exploiter et quand explorer.

Quelles sont les applications possibles en marketing ?

Le modèle des bandits manchots est extrêmement versatile, puisqu’il peut s’appliquer dès que l’on a un choix séquentiel entre plusieurs actions, et que l’on peut s’appuyer sur l’observation de récompenses pour faire un choix éclairé.

Choix de contenus / Recommandation

Le choix d’une machine à sous de l’exemple ci-dessus peut être remplacé par n’importe quel type d’action donnant lieu à une récompense. On peut donc imaginer que l’on a le choix entre plusieurs contenus/bannières à proposer à un utilisateur à chaque fois qu’il se connecte sur un site, et que l’on est récompensé par un clic (ou un autre KPI à définir) dès que l’utilisateur est satisfait par la proposition. A supposer que les contenus précédents n’influencent pas la réaction de l’utilisateur, ce cas d’usage est une application directe de la théorie des bandits manchots. Cet exemple peut aussi bien sûr être étendu à l’envoi d’e-mails ou à la recommandation de produits.

Recherche du meilleur e-mail / contenu / landing page ou de la meilleure bannière

Nous n’avons parlé jusqu’ici que de la version “classique” des bandits manchots, où l’objectif est de maximiser la récompense cumulée. Un objectif alternatif est d’apprendre quelle est la meilleure action, ou encore quelles actions sont meilleures qu’une certaine baseline. Ces modèles sont rassemblés sous le nom de bandits de pure exploration (l’exploitation n’est en effet plus nécessaire dans ce contexte.). Ils résolvent un problème proche de l’A/B testing. En effet, l’A/B testing consiste à trouver, entre plusieurs traitements, le plus performant. Il demande de diviser à l’avance la population en deux sous-populations : celle qui recevra le traitement A, et celle qui recevra le traitement B.

A l’inverse, un algorithme de bandits manchots assignera séquentiellement les individus qu’il doit traiter au traitement A ou B selon les récompenses qu’il a observées sur les individus précédents. Cela permet soit d’arriver plus vite à trouver le meilleur avec un pourcentage d’erreurs donné à l’avance, soit d’arriver à un résultat plus significatif dans le même temps. Ce cadre convient par exemple si l’on veut tester plusieurs versions d’un e-mail, ou d’une bannière avant de choisir la version à envoyer à la majorité de la population. Ce modèle est aussi particulièrement pertinent pour le test de différentes landing pages. Éventuellement, on pourrait aussi choisir des traitements plus compliqués, comme par exemple mail + bannière versus mail + SMS…

Bidding en RTB

Le choix du bid pour une campagne en RTB peut aussi être formulé comme un problème de bandits manchots. Les actions sont alors les enchères (qui peuvent être, selon le choix de modèle, discrètes ou continues) et la récompense le clic ou encore l’achat.

Conclusion

Les bandits manchots constituent un modèle statistique qui modélise le choix séquentiel entre plusieurs actions générant des récompenses différentes. Il peut servir en marketing dans des cas extrêmement divers, qui vont du choix de contenu au choix de bid dans des enchères en RTB. Chez Numberly, nous étudions ce dernier sujet avec attention. L’application des bandits manchots au choix de bid est développée dans cet article, que nous vous encourageons à lire si vous voulez en savoir plus.